Эволюция обмена трафиком

Одновременно с развитием интернет-технологий перед операторами стояла, стоит и будет стоять достаточно непростая задача – как обеспечить максимально качественный обмен данными между участниками рынка. Мировые центры обмена трафиком находятся тут на гребне новых технологий, поскольку крайне важно обеспечить не только высокоскоростной обмен данными, но и иметь необходимые запасы прочности инфраструктуры с учетом дальнейшего роста объема передаваемых данных. Именно о технологиях развития точек обмена трафиком мы и поговорим сегодня.

У истоков

В России в 1995 году (в этом году исполняется 25 лет с того знаменательного момента) была создана первая точка обмена трафиком. Обслуживание этой сети передали в руки компании РосНИИРОС. Оборудование для «первой» точки долго искать не стали. В те годы у РосНИИРОС активно развивалась сеть FDDI, поэтому решили применить один из таких коммутаторов для начала проекта. Это была Cisco Catalyst 1200. Сеть решили запустить по технологии Ethernet, а FDDI использовать не стали. Всего восемь портов Ethernet было достаточным для начала проекта. Уникальное оборудование по качеству и надежности исполнения. До сих пор такое оборудование функционирует исправно и стоит сейчас в музее MSK-IX.

Итак, начало положено – казалось бы, чего проще: поставили коммутатор, включили туда операторов связи — и точка обмена трафиком готова. Так и было какое-то время. Площадка росла и развивалась, появлялось все больше новых игроков рынка, и она прирастала все новыми участниками.

Однако с первых же дней стало понятно, что за этой кажущейся простотой лежит немалая техническая работа. Участники включались разные, с разным оборудованием, политиками маршрутизации и правилами работы своих сетей. В то время инженеров, обладающих глубокими знаниями протоколов, специфики работы оборудования, было довольно мало — и были велики риски ошибок. И практически с первых дней эти ошибки стали влиять на инфраструктуру обмена трафиком. Стало понятно, что просто коммутатор с объявленными правилами игры мало спасает от ошибок участников. Стали появляться первые технические правила, выстраданные болью и возможными проблемами во взаимодействии операторов. Появилось и новое оборудование. Сеть плавно перешла на Cisco Catalyst 3000, а затем и на Cisco 5505. Росло и количество участников. В 1997 году уже 25 провайдеров было подключено к MSK-IX.

Технологическое развитие

Интересно, что в то время технологии развивались семимильными шагами и кругом было много новых идей. Было неочевидно, что среди прочих выиграет именно Ethernet. Однако наш рынок в то время уберегало некоторое отставание от технологий Запада. Одной из таких технологий была ATM (Asynchronous Transfer Mode — асинхронный способ передачи данных). Она лишь успела появиться на российском рынке — и практически тут же уже устарела. Это позволило сэкономить достаточно много ресурсов и помогло нам впоследствии развиваться на шаг впереди. Эта же ситуация была и с сетями ADSL. В то время как во всей Европе активно строили ADSL, у нас традиционные операторы связи не были готовы к этому – это позволило внутри страны построить сети Ethernet с использованием волоконно-оптических линий связи, и сейчас почти в каждом доме есть оптика, в то время как европейские потребители довольствуются ADSL-технологиями, потому что они оказались построены раньше, на этапе новых технологий уже были и до сих пор работают и всех устраивают.

Интересен тот факт, что именно в те годы, когда вокруг появились сети ATM, на нашей инфраструктуре появились ATM LANE-модули, что позволило нам смешать две технологии (Ethernet и ATM). Это было новаторское решение, у которого на тот момент не было аналогичных применений на пиринговых платформах, но нам быстро стало понятно, что технология Ethernet это обмен «каждый со всеми», в то время как ATM требует отдельного установления стыков «каждый с каждым».

Прогресс не стоял на месте, количество участников продолжало расти. Развивалась и инфраструктура обмена трафиком – вместо одного коммутатора, расположенного на одной площадке, сеть стала распределенной. Это повышало надежность и резервируемость — появилось три коммутатора на ММТС-9 в Москве. Интересно, что в России того времени появлялось множество операторов и главное наше отличие от крупнейших европейских центров обмена трафиком было в том, что у нас было в десятки раз больше уникальных автономных систем. Мы одни из первых задумались над созданием удобного для всех участников механизма обмена маршрутами. Сначала для этой цели были выбраны маршрутизаторы Cisco. К сожалению, они добавляли номер автономной системы IX в маршруты, но других решений на тот момент не было. Шли постоянные доработки этой системы как со стороны производителей, так и со стороны нашей технической службы. Cisco реализовала даже специальную версию операционной системы IOS для нужд точек обмена трафиком (с прозрачной работой Route Server). Однако в результате длинных и сложных тестов нами был выбран программный подход к решению этой задачи, и мы ушли от зависимости производителей сетевого оборудования.

В Москве продолжали строиться новые дата-центры, и одна площадка на ММТС-9 уже не могла вмещать всех операторов. В 2000 году M9-IX расширилась и появилась MSK-IX, было построено оптоволоконное кольцо, объединяющее сразу четыре точки в разных частях города, пропускная способность была рекордной по тем временам – 1 Гб/с.

Для технической службы построение распределенной топологии было вызовом — стало понятно, что не обойтись без протокола резервирования кольцевой топологии. В то время выбор был невелик, и было принято решение остановиться на STP (Spanning Tree Protocol). Он вполне отвечал запросам того времени, но имел существенный недостаток — кольцо всегда было разорвано — и одна линия связи была пустой, в то время как другие испытывали повышенную нагрузку. Применение этого протокола стало накладывать также дополнительные требования к участникам. Пришлось выстраивать фильтры на границах сети, чтобы избежать регулярного перестроения Spanning-Tree при смене оборудования участников. Сколько было копий сломано, чтобы выстроить конфигурацию правильным образом и защитить сеть MSK-IX.

Интерес к нашей инфраструктуре рос с каждым днем. Нам стали предъявлять все более высокие требования к качеству и надежности. Мы особо уделяли внимание модернизации самой платформы, но не могли оставлять в стороне и надежность стыков участников.

Многие задумались о резервировании своих подключений к IX. Стали появляться резервные стыки с MSK-IX. Не у всех участников была возможность резервировать свою собственную сеть, но стык с IX все хотели иметь зарезервированный. Мы столкнулись с архитектурной проблемой — нельзя задать IP-адреса из одной подсети MSK-IX на разных интерфейсах одного устройства. В результате была запущена вторая IP-сеть с другим блоком адресов на MSK-IX и мы попросили участников поднять дополнительные адреса на их оборудовании. Мы постоянно работали над повышением качества сети и уже в 2001 году применили новые технические подходы и установили Cisco 6506 в качестве основного коммутатора системы. Cisco была обеспечена двойным супервизором и двойными блоками питания, что повышало надежность в случае отказа какого-либо элемента устройства.

Все эти решения накладывали еще больше требований к производителям оборудования, и мы активно участвовали в создании общего для всех платформ обмена трафиком документа IXP-Wishlist. По сути, был создан ключевой европейский документ для взаимодействия платформ обмена трафиком с производителями оборудования, где описывались методики, подходы и требования для реализации обмена трафиком. Требования складывались весьма специфичные, учитывая разнообразие подходов операторов к построению сетей и применению решений, способных нарушить работоспособность пиринговой экосистемы. Особенно много усилий было направлено на блокировку всевозможных «петель» и предупреждение их на самых ранних стадиях. Бриджевые петли крайне негативно влияли на работу сети и могли в мгновение остановить работу участников.

В то же время рынок специализированных устройств стал активно расширяться и на рынок стали выходить новые игроки, заинтересованные создавать все более мощные и функциональные устройства.

Появилось сообщество Euro-IX (ассоциация европейских точек обмена интернет-трафиком), членом которой стала MSK-IX. Деятельность ассоциации строилась, исходя из следующих целей: объединение усилий точек обмена трафиком в поиске оптимальных технических и административных решений, отстаивание единой позиции в диалоге с производителями оборудования и обмен опытом между специалистами по построению пиринговых платформ. MSK-IX вошла в пятёрку крупнейших точек обмена трафиком.

Бизнес-требования продолжали расти. Резервирование маршрутов, инфраструктуры, наращивание портовой емкости, возникли задачи по качеству передачи данных. Оборудования Cisco 6500 уже явно было недостаточно, архитектура имела ряд аппаратных ограничений и не была застрахована от потерь трафика в случае перегрузки внутренней шины данных. В технической службе MSK-IX продолжался активный процесс по поиску новых решений. Были проведены испытания нескольких платформ и по совокупности факторов выбран производитель оборудования Force10 (сейчас DellForce10). Поскольку одновременно заменять все оборудование не предоставлялось возможным, то был разработан поэтапный план миграции — с тем, чтобы минимально затронуть работоспособность сети. Таким образом, сеть стала многовендорной и это добавило еще правил в общую копилку требований к участникам и их оборудованию. Этот процесс продолжался и продолжается до сих пор. Force10 сменила компания Extreme Networks, а затем и оборудование Huawei. Каждый раз техническая служба руководствовалась в первую очередь техническими аспектами выбора. Исторически, каждые 3-4 года ситуация на рынке меняется, выходят на арену все новые игроки, в то время как старые не всегда выживают, либо теряют интерес к этому сегменту рынка. Именно поэтому выбор платформы — это постоянная задача технической службы. Одним из направлений рутинной деятельности развития пиринговой платформы является поиск решений, подбор платформ и поиск новых производителей оборудования, продолжительные и сложные тесты в лаборатории, прежде чем решение дойдет до применения в производственном процессе. Это нелегкая и интересная задача.

С ростом сложности применяемых решений мы стали понимать, что невозможно запускать сервисы, используя исключительно описание документации. Требуется длительная и кропотливая работа в лаборатории. Это ежедневная и непростая задача по моделированию необходимых данных с целью проверки, обкатки решений и четкой диагностики во взаимодействии с производителями. На рынке мало решений, пригодных к использованию в пиринговых сетях без дополнительных доработок, и от того, насколько оперативно производитель готов сотрудничать, внедрять специальные решения, зависит надежность и стабильность нашей сети. Для принятия решений о внедрении новых технологий применяются высокопроизводительные устройства для нагрузочного тестирования. Преимущество этого подхода не только в том, что такое оборудование способно генерировать большие потоки данных, но и в том, что оно также способно имитировать работу участников и контролировать целостность и качество передаваемых через нашу платформу данных.

Новые услуги, новая архитектура

Новым вызовом для технической службы явилось внедрение и развитие нового проекта MSK-IX — «Медиалогистика», — который позволил транслировать телевизионные и радиосигналы с применением инфраструктуры MSK-IX. Трансляция ТВ-сигналов потребовала еще более критичного отношения к качеству передаваемого трафика. Даже микропотери трафика, которые могли пройти незаметно при использовании TCP, стали фиксироваться при передаче ТВ-сигналов. Внутри платформы нами было реализовано обеспечение качества передачи (QoS) и дополнительно был реализован мониторинг микропотерь на всей сетевой инфраструктуре. Накопленный опыт, по сути, уникален, поскольку ни в одной крупнейшей точке обмена трафиком не передается внутри ядра такое количество мультикаст-данных с гарантированными характеристиками доставки. По сути, мы получили в распоряжение сервис, удовлетворяющий высоким требованиям качества, которые нами и были реализованы в рамках платформы.

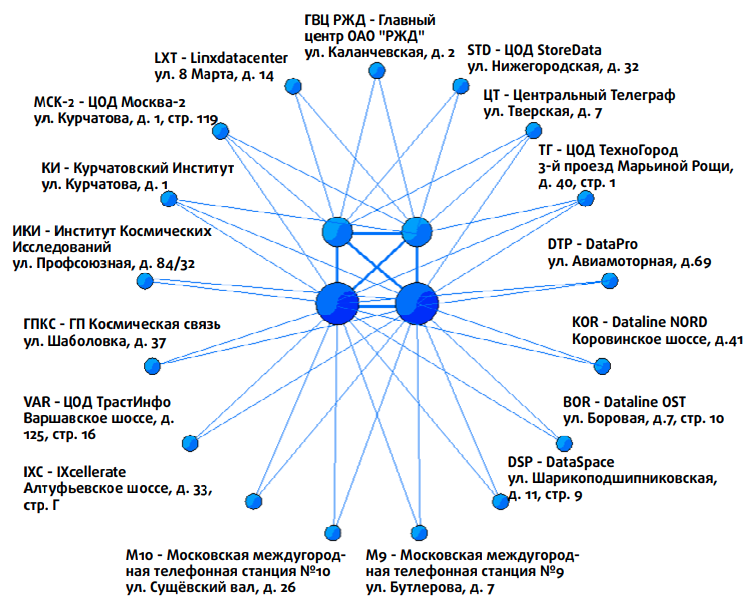

На текущий момент топология сети построена по принципу двойного «ядра», в центре которого установлены коммутаторы Huawei с применением технологии MLAG. Ядра расположены в географически разнесенных частях города в независимых энергозонах (рис. 1). Остальные площадки стыкуются либо с применением оптики, либо с применением WDM-решений с двумя ядрами для резервирования. Особым случаем выглядит площадка на ММТС-9. Исторически на этой площадке высокая концентрация интернет-провайдеров и наиболее нагруженное оборудование, эта площадка критична для текущей инфраструктуры. MSK-IX имеет три точки присутствия на ММТС-9, которые выглядят отдельными площадками. Стыковать их все отдельно с ядрами — не самая оптимальная идея (так как увеличит задержки между этажами М9 и понизит надежность), и поэтому для этой площадки нами была выработана отдельная схема мини-ядер. Все оборудование на ММТС-9 стыкуется с этими двумя независимыми мини-ядрами, которые в свою очередь стыкуются с основными ядрами платформы обмена трафиком. Такая схема обеспечивает простоту диагностики и помогает проводить работы на каждом плече (ядре) сети, не затрагивая функциональность общей инфраструктуры. Применяемые нами подходы позволяют избегать каких-либо простоев сети, успешно масштабировать решения с опережением развития скоростей подключений участников. Наши решения обеспечивают высокий уровень надежности на данном этапе развития технологий.

Зарубежный опыт

А что же происходит на международной арене с оборудованием для точек обмена трафиком?

По сути, сейчас рынок разделился и практически сети крупнейших точек обмена трафиком построены с использованием разных вендоров и применяют разные подходы и решения. AMS-IX применяет вот уже много лет оборудование Brocade (сейчас Extreme Networks). У них внедрено достаточно интересное решение по резервированию клиентских подключений. Оптические подключения резервируются с помощью оптических переключателей. Хотя и стоимость такого решения весьма высока (многопортовые оптические переключатели — недешевое удовольствие), она еще и подвержена дополнительным рискам. Часто при проведении работ коллегам из AMS-IX приходится переключать сразу группу портов на другое устройство, причём делать это одномоментно, чтобы исключить потери трафика. Плюс оптические переключатели сами вносят дополнительную точку отказа. Однако за много лет коллегам удалось выстроить надежную сеть, и она тоже показала свою эффективность.

Немецкие коллеги из DE-CIX построили свою основную сеть на платформе Alcatel Lucent (сейчас Nokia). Их сеть активно масштабируется на другие платформы под их управлением и развивается по всему миру. Интересно также выглядит подход компании LINX (Лондон). Несколько лет назад ими было принято решение о строительстве сразу двух параллельных точек обмена трафиком на разном оборудовании. Для этой цели сейчас применяется Juniper Networks и EdgeCore. Такой подход позволил не только зарезервировать инфраструктуру, но и проводить плановые работы по отдельности на той или другой линейке оборудования, а также тестировать и внедрять новые решения. В частности, они реализовали новый технологический подход на оборудовании Edgecore, где оборудование выступает в роли «whitebox» (простейших «коробок» с коммутацией пакетов), а внешняя компания IP Infusion реализовала функционал обмена трафиком на этой платформе.

Интересно, что технология Ethernet показала свою эффективность не только в рамках городского обмена, но и при построении распределенных сетей. Один из крупнейших центров обмена создан в Бразилии. Коллегам удалось объединить в единую сеть по всей стране свыше 30 центров обмена трафиком, крупнейшие из которых находятся в Сан-Паоло и Рио-де-Жанейро. Азиатские центры обмена трафиком имеют свою специфику в применении технологий. Например, коллеги в JPIX обслуживают сразу две сети в разных городах. Топология этих сетей сделана по образу звезды, где центр расположен в Токио и Осаке. В целом, решений на рынке платформ обмена трафиком достаточно много и они постоянно дорабатываются, и в крупнейших центрах применяются нестандартные подходы к управлению и обслуживанию подобных сетей.

Если же заглянуть на кухню точек обмена трафиком, то несложно заметить, что многие базируются на традиционной топологии Layer 2. При доступности современных протоколов и решений этот подход выглядит некоторым атавизмом. Однако это далеко не так. Многие крупнейшие точки обмена трафиком (в том числе и наша) регулярно ищут новые способы решения задач и проводят испытания таких технологий, как OpenFlow, VXLAN, VPLS и других, но важно отметить, что основу всех решений составляет надежность, управляемость и масштабируемость, и немаловажным фактором выступает простота «траблшутинга» (troubleshooting). И тут, как ни странно, на настоящий момент побеждает именно простота Layer 2-топологии, применяемой на нашей платформе обмена, хотя, безусловно, будущее нам еще покажет.

За 25 лет своего существования MSK-IX из единственного коммутатора превратилась в распределенную надежную высокоскоростную инфраструктуру обмена трафиком. Это развитие шло в ногу с развитием самого Интернета – менялись скорости, технологии и оборудование, появлялись новые приложения. Неизменным остался дух сотрудничества, позволивший нам вместе с операторами-участниками вывести MSK-IX на мировой уровень. Несмотря на солидный по Интернет-меркам возраст, MSK-IX по-прежнему молода и готова к будущему.