Интернет больших данных

Большие данные выросли из концепции и броского термина в набор технологий, архитектур и приложений, которые, совмещенные с современной аналитикой, предоставляют практически неограниченные возможности для оптимизации процессов, а также открывают новые возможности для научных исследований. Данная статья предлагает краткий структурированный обзор развития этой области и тенденций создания инфраструктуры обмена и обработки данных, которые можно определить как будущий Интернет (больших) данных. Статья приводит примеры стандартизации, проектов и инициатив для обеспечения доступности, обнаружимости и совместимости данных.

Вступление

Большие данные (БД) являются устоявшимся термином и как концепция обозначают данные чрезвычайно большого объема, недоступные обработке традиционными программными средствами с реалистичными сроками. К характеристикам БД относят их объем, скорость генерации и обработки, а также степень разнообразия типов и природы данных. От БД неотделимы технологии их обработки и анализа, широко используемые практически во всех областях деятельности человека и частью бизнес-процессов современных фирм. Большие данные являются результатом современных бизнес-процессов, промышленных и технологических процессов, а также социальной активности человека в соцсетях. На уровне вычислительных и коммуникационных технологий/процессов данные представляют собой основной продукт, цель и инструмент

работы большинства приложений и процессов. Большие данные, совмещенные с современной аналитикой, предоставляют практически неограниченные возможности для оптимизации процессов, а также открывают новые возможности для научных исследований. Широкое использование данных в бизнесе привели к появлению так называемых предприятий, управляемых (и зависимых от) данными (Agile Data Driven Enterprise), то же самое происходит с современной наукой, которая становится также зависимой от данных и все больше использует методы исследований

на основе интенсивного анализа данных (Data Driven Science and Research).

Развитие технологий и инфраструктуры больших данных привело к появлению науки о данных (Data Science) и сильно стимулировало развитие облачных вычислений (Cloud Computing), которые совместно смогли обеспечить необходимые ресурсы и платформу/ресурсы для обработки, хранения и передачи/обмена больших данных. В свою очередь, развитие инфраструктуры больших данных

и облачных вычислений привело к значительным изменениям в том, как работает и развивается современный Интернет. Многие ветераны-исследователи Интернета, а также профессиональные организации в области телекоммуникационных технологий (таких как ITU-T, TMForum) видят тенденцию эволюции современной телекоммуникационно-информационной инфраструктуры от Интернета к Интернету вещей и к Интернету данных. Большинство современных приложений в явном или неявном виде используют элементы распределенной и глобальной инфраструктуры данных, по сути, Интернета данных. Мы можем ожидать множество инноваций и приложений на этом технологическом уровне, которые должны обеспечить возможность глобального обмена, интеграции и даже

торговли данными при условии соблюдения суверенности, доверительности и защиты персональных данных. Множество инициатив существует в этой области в Европе и в мире, включая поддержку Европейской рамочной программы Horizon 2020.

Свойства больших данных

Первые определения больших данных были предложены в 2011 году. Определение аналитической фирмы IDC можно рассматривать как достаточно консервативное: «Новое поколение технологий и архитектур, предназначенных для экономически эффективного извлечения полезной значимой информации из большого количества разнообразных данных посредством эффективного сбора, обнаружения и анализа» (IDC, 2011).

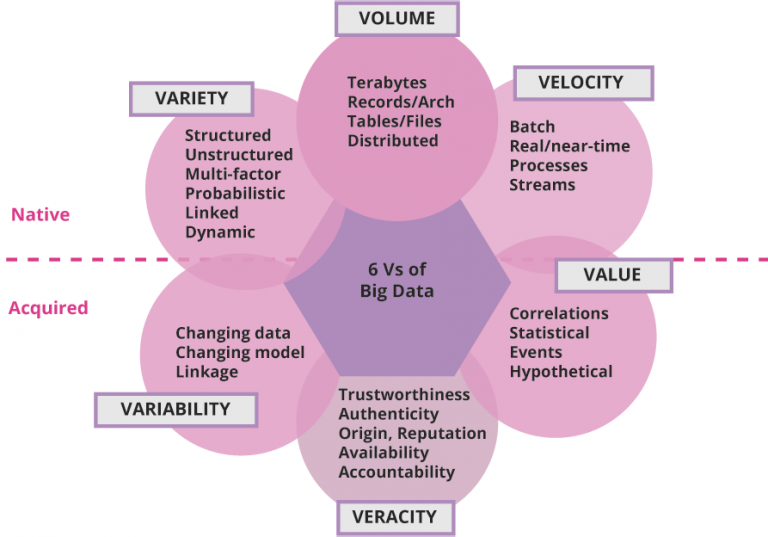

Аналитическая фирма Gartner предложила определение больших данных как информационных активов большого объема, высокой скорости, большого разнообразия, которые требуют новых эффективных форм обработки информации для улучшенного понимания и принятия решений (Gartner, 2011). Такое определение фактически ссылается на «основные 3V» больших данных (Volume,

Velocity, Variety — Объем, Скорость, Разнообразие), указывает на новые методы аналитики, необходимость учитывать целевое применение БД.

Однако наиболее популярным стало определение от Forrester Research (2013): «Большие данные представляют массивный объем структурированных и не структурированных данных, которые настолько велики, что их сложно обрабатывать, используя традиционные базы данных и программные средства». Эффективность такого определения, появившегося в то время, когда

появились первые средства для работы с большими данными и наметились определенные тенденции в области разработки и применения БД, в основном связана с разработкой нереляционных баз данных (NoSQL), средств хранения БД и масштабируемых средств массивной обработки, таких как MapReduce, Hadoop, Spark.

Изначально БД характеризовались тремя основными свойствами, так называемыми 3V. В дальнейшем к базовым 3V добавились свойства больших данных, которые они приобретают в процессе обработки и которые являются основополагающими для определения требований к системам обработки больших данных: Value, Variability, Veracity (Значимость, Изменчивость, Доверительность).

Рисунок 1 представляет графически базовые и приобретенные свойства БД, которые составляют 6V больших данных; также на рисунке перечислены основные характеристики, которые относятся к соответствующим свойствам.

Однако быстрое развитие и внедрение технологий БД в бизнес и промышленность было уже хорошо подготовлено развитием систем и платформ для научных исследований, создавших предпосылки для реализации новых методов научных исследований, которые были определены ученым в области компьютерных наук Джимом Греем (Jim Gray) как четвертая парадигма научных исследований: «Средства и технологии для такой наукоемкой науки, управляемой данными, являются настолько иными, что имеет смысл отличать науку, управляемую данными, от вычислительной/компьютерной науки как новую четвертую парадигму научных исследований». (Grey, 2010) Третья парадигма научных исследований уже использовала вычислительные технологии, но в основном для моделирования и симуляции научных теорий и моделей, разработанных классическими теоретическими (аналитическими) и экспериментальными научными методами. К моменту написания книги Грея наука уже стояла перед задачами, которые имели дело с большими объемами данных и требовали новой инфраструктуры для обработки экспериментальных данных, включая обеспечение сотрудничества большого количества всемирно/глобально распределенных групп ученых.

Примеры применения больших данных в науке и промышленности

Давайте рассмотрим примеры использования больших данных в науке и технике, которые создали предпосылки и стимулировали развитие технологии БД.

Большой адронный ускоритель LHC и инфраструктура больших данных LCG

В первую очередь применение БД относится к глобальному международному проекту по обнаружению частицы Хиггса, бозона, для чего в 2008 году было закончено строительство величайшего научного инструмента — Большого адронного ускорителя (Large Hadron Collider, LHC) в ЦЕРНе в Швейцарии. Строительство ускорителя заняло несколько лет и потребовало не только сотрудничества ученых со всего мира, но и решения новых задач сбора, хранения, распространения и обработки экспериментальных данных, производимых датчиком столкновения пучков протонов

ALICE, разогнанных до околосветовой скорости. Фактически само столкновение частиц продолжается в течение 10 мс, скорость производства данных составляет единицы РВ (Petabyte) в секунду. Суммарное количество данных, производимых в экспериментах в течение месяца, составляет более 10 РВ, данные должны быть собраны/зарегистрированы, первично обработаны, сохранены в

центрах хранения данных первого уровня и распространены до уровня региональных научных центров обработки данных по всему миру. Обработка всего объёма экспериментальных данных не могла быть выполнена средствами одного вычислительного центра в то время (да и сейчас это тоже невозможно). Таким образом, случай LHC демонстрирует пример двух важнейших свойств больших данных: большой объем и большая скорость, — и технические задачи, которые сопряжены с этим. Как известно, работа ускорителя и глобальное сотрудничество исследователей всего мира увенчались успешным открытием бозона в 2013 году.

Для создания инфраструктуры обработки данных, производимых ускорителем, международное сообщество финансировало несколько проектов по созданию Worldwide LHC Grid (WLCG), которые включали проект EGEE (Enabling Grids for E-sciencE), финансированный европейскими рамочными программами FP6-FP7 в 2004-2010, проект Open Science Grid в США, финансированный странами-участниками проекта. В настоящее время инфраструктура европейского грида поддерживается ассоциацией «Европейская грид-инициатива» (EGI –

European Grid Initiative)5 совместно с координационными органами во всех европейских странах. EGI предоставляет вычислительные ресурсы (как суперкомпьютеров, так и облачных центров данных) практически для всех наукоемких европейских научных проектов, а также продолжает развитие инфраструктурных сервисов грид, которые в настоящее время работают на основе стандартных облачных платформ.

Результатом проекта EGEE и соответствующего международного сотрудничества было не только создание собственно инфраструктуры для обработки научных данных, но и фактически ускорение появления таких новых направлений в области вычислительных и информационных технологий как Web Services (включая SOAP- и REST-протоколы), вычислительные гриды (Computer Grids) и модель управления вычислительными задачами в распределенных центрах данных, федеративная модель управления идентификацией пользователей и федеративный доступ к сетевым вычислительным ресурсам и данным.

Многие идеи по доступу и интеграции данных, изначально предложенные в компьютерных грид-системах, были развиты в современной архитектуре облачных вычислений (Cloud Computing) и федеративного доступа к распределенным сервисам. Это также стимулировало широкую международную стандартизацию, целью которой является обеспечение эффективного доступа к распределенным вычислительным ресурсам, включая обеспечение безопасности данных. Другие направления стандартизации включают разработку методов и форматов описания, идентификации и поиска данных, таких как метаданные, постоянные/глобальные идентификаторы (PID – Persistent Identifiers), доверительные распределенные вычислительные модели.

Большие данные в промышленности и бизнесе

Промышленные процессы и машины в настоящее время полностью компьютеризованы и автоматизированы, что приводит к генерированию огромного количества данных, которые необходимо сохранять и обрабатывать для оптимизации процессов и — в конечном итоге — для увеличения безопасности и уменьшения затрат. Промышленный Интернет вещей (Industrial Internet of Things) в настоящее время включает в себя и опирается на такие технологии как облачные вычисления, граничные вычисления (Edge Computing), автоматизация и промышленные роботы, искусственный интеллект и цифровые двойники (Digital Twins), в основе которых лежит работа с большим объемом разнообразных данных, требующих быстрой обработки для управления процессами или принятия решений. Перечисленный комплекс технологий предъявляет свои требования к инфраструктуре больших данных, которые включают кроме общих требований к хранению, обработке и доступу к большим данным дополнительные требования по защищенному обмену данными, стандартизации описания данных, качеству данных, хранению истории данных и пр.

В случае авиационной промышленности сбор и хранение данных о работе всех систем самолета является основой прогнозного мониторинга, который общепризнано позволяет существенно снизить стоимость обслуживания самолета и повысить безопасность. Известно, что четырехмоторный самолет Boeing 747 Jumbo производит 640 Тбайт данных за время трансатлантического перелета, и все это должно быть умножено на более чем 25 тысяч полетов каждый день. В случае инцидента данные о необходимых системах должны быть извлечены и обработаны, используя необходимые методы машинного анализа данных. Качество анализа и диагностики зависит в большой степени от цифровой модели самолета (по сути, цифрового двойника) и качества данных. Характерная ситуация в расследовании авиационных инцидентов требует обмена данными между различными организациями и фирмами, часто конкурирующими, и это требует создания соответствующей инфраструктуры для доверительного обмена данными и безопасной доверительной среды обработки, которая бы

защищала как входные и выходные данные, так и алгоритмы, которые также могут представлять коммерческую тайну.

Классическим примером использования больших данных являются поисковые системы. Поисковая система Google, которая является абсолютным доминантом на рынке поисковых систем, использует все наилучшие системы и алгоритмы для обработки БД с целью предоставления качественных результатов (и в наименьшее время), ожидаемых пользователями. Результатом исследований в Google и других фирмах в области поисковых систем и инфраструктуры БД стало появление открытого программного обеспечения для обработки больших данных, такого как Hadoop, MapReduce, HBase, Pig, Hive, которые составляют основу современных технологий больших данных. Все указанные приложения позволяют работать с глобально

распределенными данными в масштабе Интернета.

Кроме основного бизнеса предоставления поисковых результатов, поисковые системы и Google, в частности, предоставляют платные целевые объявления/рекламу, которая является одной из основных форм зарабатывания денег на поисковом бизнесе. Таргетированная реклама (англ. targeted advertising) включается в страницу поисковых

результатов на основе контекста запроса, истории запросов

пользователя или дополнительно других данных о пользователе, собираемых поисковой системой. Но критически важным критерием для эффективности такой рекламы является ее включение в ответную страницу в течение 40 мс после получения запроса, в противном случае внимание пользователя будет переключено на собственно результаты поиска. Оптимальное решение этой задачи является одной из проблем как алгоритмов обработки данных, так и построения самой инфраструктуры данных.

Другие примеры использования больших данных в науке и промышленности

Исследования генома и генетические исследования в общем являются одним из примеров использования различных аспектов больших данных, включая обработку данных секвенирования генома, хранение эталонного генома и доступ к нему, а также хранение индивидуальных геномов при массовых исследованиях. Согласно различным оценкам, полное секвенирование индивидуального генома человека производит около 250 Гбайт исходных данных

(собственно объем генома оценивается в 4,23 Гбайт), последующая обработка с целью диагностики может потребовать доступа к геномным базам данных и производить дополнительно большой объем данных. Эффективное использование этих данных для научных исследований и в медицинских целях ставит задачу создания специальной инфраструктуры геномных данных, которая бы позволяла семантический поиск по шаблонам и доступ к необходимым частям генома.

В Европе создана специальная организация ELIXIR, которая координирует европейские проекты по исследованию генома и поддерживает инфраструктуру для доступа к базам данных геномов, включая эталонный геном человека, приложения для геномных исследований, вычислительные ресурсы. Одной из задач инфраструктуры ELIXIR является распределение и обслуживание реплик базы данных геномов от центральной базы данных до национальных баз данных и тех, которые используются в больших исследовательских центрах, включая контроль доступа, качество и

защиту данных.

Эталонная архитектура систем больших данных и другие стандарты

Работа с распределенными и разнообразными данными больших объемов с самого начала потребовала стандартизации на уровне инфраструктуры, описания и идентификации данных, что стало предметом работы многих организаций по стандартизации, как международных, так и национальных или отраслевых, общее направление которых можно определить как создание Интернета (больших) данных. В этом разделе мы рассмотрим эталонную архитектуру больших данных (NIST Big Data Reference Architecture, NBDRA), предложенную NIST (National Institute of Standards and Technologies), а также работы Research Data Alliance (RDA), направленные на создание стандартов описания данных, определения метаданных, а также определение постоянных идентификаторов PID (Persistent Identifier) данных с соответствующей инфраструктурой.

Эталонная архитектура систем больших данных NIST

Стандарт NIST SP1500 включает три главных компонента: определение концепции/парадигмы больших данных, определение эталонной архитектуры больших данных, определение специалиста по данным (Data Scientist) как новую профессию (NBDRA, 2020).

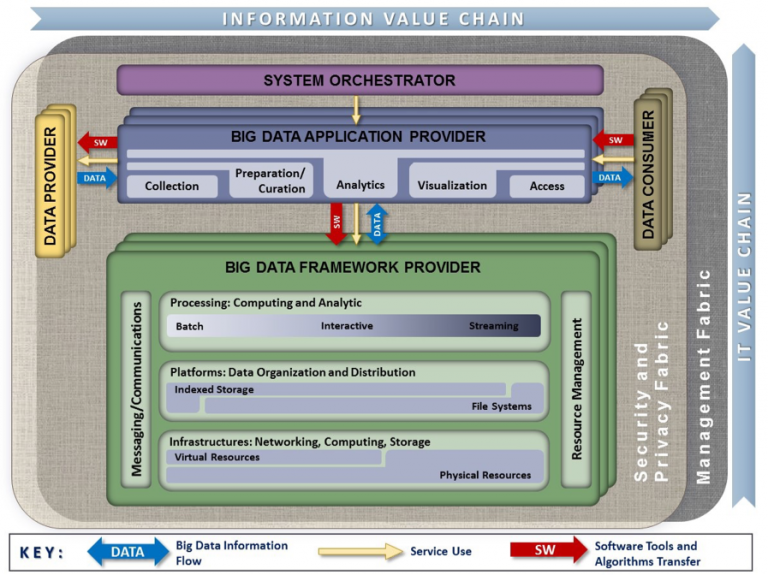

Рисунок 2 изображает предложенную архитектуру, которая включает главные функциональные компоненты, сгруппированные по отношению к основным функциональным ролям в экосистеме больших данных: провайдер инфраструктуры и платформ больших данных (Big Data framework provider), провайдер приложений больших данных (Big Data application provider), системный интегратор (system orchestrator), а также провайдеры (data provider) и потребители (data consumer) данных. Платформа и инфраструктура больших данных включает, по сути, облачные инфраструктурные сервисы, платформу управления данными, включая реляционные и нереляционные (SQL/NoSQL) базы данных, а также платформы и средства для анализа больших данных, такие как Hadoop и Spark, с соответствующими компонентными сервисами.

Группа функций, относящаяся к провайдеру приложений больших данных, включает основные функции процесса обработки или жизненного цикла данных: сбор данных, подготовка, анализ, визуализация и презентация результатов конечному потребителю, которым может быть как человек, так и процесс. NBDRA также включает общие функции управления ресурсами и процессами, инфраструктуру безопасности и обмена сообщениями.

NBDRA построена в двух координатах: цепочка создания значимости данных от сбора данных до целевого использования и инфраструктурные уровни обработки данных от общих компьютерных или облачных ресурсов до специализированных платформ для анализа данных.

Более широкое определение архитектуры систем больших данных должно также включать определение формальных моделей больших данных, включая форматы и идентификаторы данных, метаданные, семантические модели, которые важны для межсистемного и межплатформенного обмена, интеграции и совместимости данных (BDAF, 2014).

Фабрики данных и постоянные идентификаторы данных PID

Группа Data Fabric Interest Group (IG-DF) в RDA ставит своей задачей определение общих компонентов и сервисов, характерных для типичных процессов создания и использования данных в ежедневной практике научных и промышленных лабораторий, с целью создания условий использования и интеграции данных из различных областей для реализаций междоменных и межотраслевых

исследований. Глобальной целью IG-DF является создание Интернета данных как инфраструктуры для обмена научными данными в процессе всех этапов обработки данных с той же простотой, как это происходит с обычными данными в Интернете. На начальном этапе своей работы IG-DF детально исследовала опыт создания и развития Сети и привлекала экспертов, имеющих опыт разработки интернет-стандартов и активно работающих с IETF (Internet Engineering Task Force).

Результатом работы IG-DF и соответствующих рабочих групп стала разработка регистра типов данных, директории метаданных, постоянных идентификаторов данных PID (Persistent Identifier). Предполагается, что PID сможет выполнять такую же роль для идентификации, поиска и доступа к данным, какую IP и доменные адреса играют для доступа ко всевозможным ресурсам в Интернете.

Общие требования к инфраструктуре больших данных

Для решения задач эффективной обработки данных с целью извлечения максимальной пользы из доступных данных и оптимизации процессов, которые зависят от данных и управляются ими, будущая инфраструктура больших данных должна обладать рядом свойств (соответствовать ряду требований), таких как:

- широкая автоматизация всех процессов обработки и управления данными, включая предоставление ресурсов и сервисов по требованию (provisioning on demand), характерных для облачных сервисов;

- преобразование всех процессов управления инфраструктурой и процессами в цифровую форму (digitalisation), постоянный мониторинг и регистрация этапов преобразования данных;

- возможность повторного использования данных, включая повторное использование для других целей и смешивание с открытыми данными, одним из важных источников которых являются социальные сети и медиа;

- глобальный доступ к данным для сотрудничающих проектов и групп исследователей, в первую очередь касающийся научных данных и научного сотрудничества;

- улучшенная безопасность инфраструктуры и защиты данных, включая персональные данные, на основе современных механизмов и сервисов безопасности, федеративного управления идентификацией пользователей и сервисов.

Существенно, чтобы будущая инфраструктура больших данных (фактически будущий Интернет данных) обеспечивала доверительную среду для обмена данными и поддерживала суверенность данных в том смысле, чтобы владелец/собственник данных сохранял контроль над использованием данных, что является принципиально важным для промышленных данных.

Другие инициативы в направлении построения Интернета больших данных

Вопрос обмена данными является важным как для науки, так и для промышленности. Одной из таких инициатив является GO FAIR Data Initiative по внедрению принципов FAIR (Findable, Accessible, Interoperable, Reusable) для обеспечения обнаружимости, доступности, совместимости и повторного использования в первую очередь научных данных, изначально предложенная европейским научным

сообществом и в настоящее время поддерживаемая всемирно, в частности, RDA и рядом проектов, финансируемых в рамках европейской рамочной программы Horizon 2020 EOSC (European Open Science Cloud) и FAIRsFAIR.

Важной инициативой по определению принципов доверительного обмена промышленными данными и созданию элементов инфраструктуры обмена промышленными данными является создание International Data Spaces Association (IDSA), которая на данный момент объединяет более 100 организаций от промышленности, науки и университетов. Эталонная архитектура, предложенная IDSA, предполагает использование современных облачных технологий и определяет ключевые функциональные компоненты для обеспечения доверительного обмена и использования промышленных данных на основе принципа

суверенности данных (Data Sovereignty).

Заключение

Эффективное использование БД является важным движущим фактором современных технологий. Большинство приложений БД используют данные из разных источников, включающих как исходные данные (например, производимые системой датчиков или социальными медиа), так и специальные наборы данных, подготовленных и обработанных другими приложениями, или данные, используемые в качестве эталонных (такие как данные геномов, звездная база данных или наборы данных для обучения

алгоритмов искусственного интеллекта). Эффективный доступ к таким данным, которые в большинстве являются распределенными, вызывают необходимость построения инфраструктуры доступа и обмена данными или, другими словами, будущего Интернета данных, на создание которого направлено много проектов и инициатив во всем мире. Создание будущего открытого Интернета данных будет способствовать дальнейшему развитию технологий и приложений, основанных на данных.

Создание Интернета данных по принципу Интернета, а также поддерживания FAIR-принципов обмена данными создаст условия, при которых больше организаций будут готовы обмениваться своими данными посредством открытых сервисов обмена данными или рынков данных.